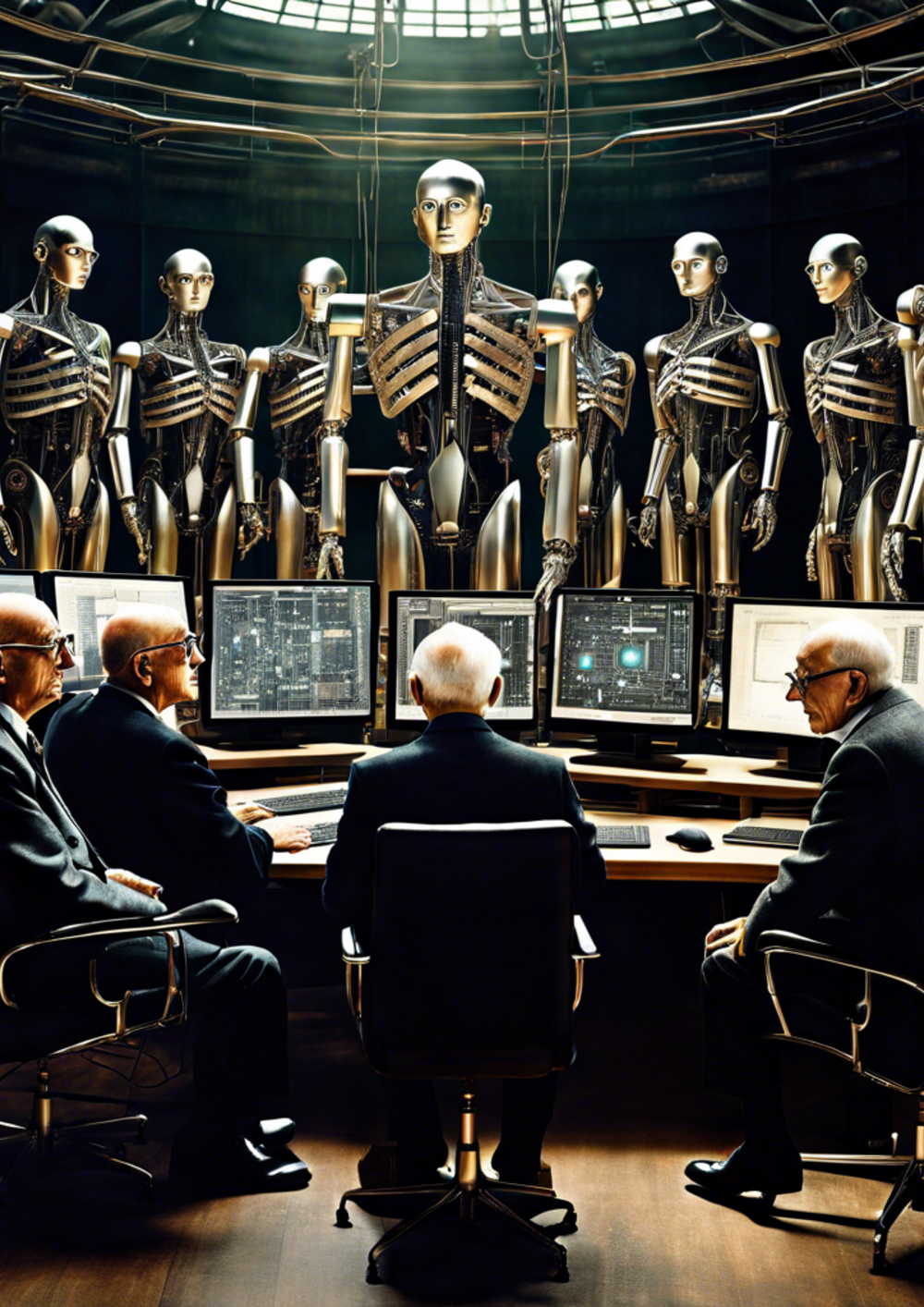

Es handelt sich um ein mit der Künstlichen Intelligenz DALL-E generiertes Bild. Der dabei verwendete Prompt lautet: "I want the main thinkers of the frankfurt school (Adorno, Horkheimer, Habermas and Marcuse) in a setting surrounded by huge technological mashines, artificial intelligence and robots."

Alles eine Frage der Technik? – KI und die Kritische Theorie

Ende November 2022 stellte das US-Softwareunternehmen OpenAI seinen KI-Chatbot ChatGPT der Öffentlichkeit vor. Selbst in der kostenlosen Basisversion erstellt das Programm eloquente Texte zu fast jedem Thema. Ein »Prompt« genügt. Die Anwendung stieß sofort auf reges Interesse. Zwei Monate nach Veröffentlichung verzeichnete ChatGPT über 100 Millionen aktive monatliche Nutzer*innen. Wer sich zu dieser Zeit im universitären oder schulischen Umfeld bewegte, konnte der Debatte um angemessene Lehr- und Prüfverfahren nach ChatGPT kaum entrinnen. Doch auch darüber hinaus schlug ChatGPT Wellen: Während Menschen in textproduzierenden oder programmierenden Berufen um ihre Arbeitsplätze bangten, begannen Unternehmensberatungen und selbsternannte Coaches damit, Step-by-Step-Pläne anzubieten, wie »auch Du« die geballte Power der künstlichen Intelligenz entfesseln kannst. Von der Diskussion über all die Falschinformationen, die sogenannten »Halluzinationen«, die das Programm produziert, noch ganz zu schweigen.

OpenAI’s neuester Coup soll mit dem Text-zu-Video-Programm »Sora« gelingen, welches voraussichtlich in diesem Jahr veröffentlicht werden soll. Sora erstellt beeindruckend realistische, bis zu einminütige Videos basierend auf schriftlicher Eingabe in fast jedem Stil mit bemerkenswerter Objektpermanenz und unter Einhaltung physikalischer Gesetze – meistens jedenfalls.

Ein lukratives Geschäft

Produkte wie diese generieren Umsatz. Nach Angaben von CBInsights steht das Unternehmen inzwischen auf Platz drei der wertvollsten Start-Ups weltweit, übertroffen nur vom chinesischen Start-Up Byte-Dance (besser bekannt für seine Social Media Plattform TikTok) und Elon Musks SpaceX. Und das obwohl OpenAI 2015 ursprünglich als ein gemeinnütziges Unternehmen gegründet wurde. So heißt es im Gründungsstatement: »OpenAI is a non-profit artificial intelligence research company. Our goal is to advance digital intelligence in the way that is most likely to benefit humanity as a whole, unconstrained by a need to generate financial return.«1 Frei übersetzt: Künstliche Intelligenz solle doch lieber von einem Forschungsunternehmen entwickelt werden, welches das Wohl der Menschheit über seine eigenen Profitinteressen stellt.

Dennoch modifizierte OpenAI 2019, kurz nach der überaus medienwirksamen Veröffentlichung des ChatGPT-Vorläufermodells GPT-2, sein Geschäftsmodell. Dem gemeinnützigen Unternehmen wuchs ein »capped profit«-Arm. OpenAI zufolge blieb seine Mission dabei unverändert: Die Suche nach dem heiligen Gral der KI-Forschung, der generalisierten künstlichen Intelligenz (Artificial General Intelligence, kurz: AGI), zum Wohle der gesamten Menschheit. Das profitorientierte Tochterunternehmen solle lediglich zur Erwirtschaftung des dafür nötigen Kapitals dienen. OpenAI warnt prospektive Investor*innen jedoch ausdrücklich, mehr als gut sichtbar in einem dick umrandeten, pinken Textfeld: Es handele sich um ein Investment mit hohem Risiko und ohne Profitversprechen. Und überhaupt, man wisse ohnehin nicht, welche Rolle Geld in einer Welt nach AGI spiele. Abschrecken ließen sich finanzstarke Geldgeber davon offenbar nicht. Microsoft versprach zuletzt Investitionen über 10 Milliarden US-Dollar.

Ethik ab Werk

Dass KI nicht nur zum Wohle der Menschheit entwickelt wird, ist keine kontroverse These. Und so sehr uns Unternehmen wie OpenAI auch den Traum von AGI verkaufen möchten – was genau an der Vorstellung so traumhaft ist, bedarf anscheinend keiner weiteren Erklärung. Gut dokumentiert sind auch etliche ethische und soziale Bedenken rund um bereits existierende KI-Modelle. Das Forschungsfeld der KI-Ethik floriert. Und auch die Politik merkt auf. KI-Richtlinien werden weltweit auf verschiedenen Organisationsebenen entwickelt. Zuletzt verabschiedete China sein neues KI-Gesetz, während ein europäischer Entwurf bereits Anfang des Jahres von allen 27 EU-Mitgliedsstaaten gebilligt wurde.

Hierbei zugrundeliegende KI-Ethikansätze und -richtlinien beschränken sich jedoch oftmals auf die technische Analyseebene. In pragmatischer Manier werden ethische Prinzipien zur Anleitung der KI-Entwicklung vorgeschlagen, Stichwort »Value Sensitive Design«. Schlagworte wie »Trustworthy AI« (das Label für ethische KI »made in the EU«) oder »Responsible AI« fassen ethische Bedenken prägnant zusammen – und stellen zugleich die Lösung vor: Ethik ab Werk. Der Algorithmus selbst soll durch verbessertes technisches Design inklusive Entwicklungsprozesse moralisch unbedenklich (vertrauenswürdig, verantwortungsbewusst…) werden. Dabei erschöpfen sich KI-Ethik-Leitlinien häufig in höherstufigen Prinzipien, welche im Anwendungsfall einiges an Interpretation bedürfen.2 Die Verantwortung hierfür liegt bei den Entwicklerteams, deren technische Fachkräfte weder einem klaren Berufsethos verschrieben, noch sich einig darüber sind, welches Ausmaß diese Verantwortung genau annehmen soll.3 Auf der Suche nach Antworten finden die Techniker stets nur weitere technische Lösungen für technische Probleme.4 KI-Ethik – alles eine Frage der Technik?

Technikkritik mit kleinem »K«

Hier gibt es Anlass zur kritischen Betrachtung. Doch trotz der gesamtgesellschaftlichen Relevanz der Thematik schweigt sich die Kritische Theorie in der hegelianisch-marxistischen Tradition der Frankfurter Schule zum Thema »KI« im Speziellen und »Technologie« im Allgemeinen bisher weitgehend aus. Einschlägige Veröffentlichungen zum Thema KI und/oder Technologie kommen zurzeit selten aus Frankfurt und ebenso wenig aus Berlin.

Ein ernstzunehmendes Gegengewicht zu prinzipiengeleiteter KI-Ethik bildet stattdessen die kritische Theorie mit kleinem »K«.5 Gemeint sind hiermit vor allem Ansätze, die nicht in der Tradition der Frankfurter Schule wurzeln: feministische Theorie, Critical Race Theory, dekoloniale Theorien und andere. Diese leisten wichtige Arbeit, indem sie die ethische Debatte politisieren und in Zusammenhänge systematischer Unterdrückung einbetten. So ist es etwa ein wohlbekanntes Problem, dass KI-Systeme dazu neigen, sexistische, rassistische und andere Vorurteile zu reproduzieren. Möchte man dieses Problem im KI-Algorithmus lösen (by design), wird es ein statistisches: »Gruppe X ist in den Outputs des KI-Systems über-/ unterrepräsentiert.« Die Lösung bedarf dann ebenfalls einer statistischen Definition sozialer Gerechtigkeit – soziale Gerechtigkeit wird operationalisierbar. Diese Folge pragmatischer KI-Ethik ist nicht bloß graue Theorie; statistisch-rechnerische Lösungen für das Problem von KI-Bias und -Fairness wurden gesucht, vermeintlich gefunden und diskutiert.6

Dem entgegen halten kritische Stimmen wie die von Anna Lauren Hoffman7, dass sich Diskriminierung nicht in ungerechtfertigten Verteilungen erschöpft. Mit anderen Worten, bei Fairness geht es nicht nur um das »richtige« Ergebnis. Auch das Zustandekommen und die Konsequenzen des Ergebnisses sind von Bedeutung. So reicht es nicht, dass die Outputs einer bereinigten KI »fair« verteilt sind – eine KI erkennt zum Beispiel die Gesichter Schwarzer Menschen ebenso zuverlässig wie die weißer Menschen. Dieses Ergebnis ändert nichts an den Strukturen, die die sozialen Kategorien Schwarz und weiß überhaupt erst produzieren. Mehr noch, um das »faire« Ergebnis zu erzeugen, müssen diese Kategorien gar notwendig reproduziert werden. Die rechnerisch-statistische Lösung ist daher eine kosmetische, die das Problem eher verschleiert als angeht.

In dieselbe Kerbe schlägt Ruha Benjamin mit ihrer Arbeit zu Race und Technik.8 Nicht nur verschleiern bereinigte KI-Algorithmen zugrundeliegende soziale Ungerechtigkeiten; mit ihrer vermeintlichen Objektivität und Neutralität können sie diese noch weiter bestärken. Denn während offene Diskriminierungen herausgefiltert werden, bleiben subtilere Formen bestehen und rechtfertigen mitunter den Fortbestand der herrschenden sozialen Ordnung. Benjamins Fazit ist schlicht: In rassifizierten Gesellschaften kann es keine neutralen Algorithmen geben. Anders ausgedrückt, es gibt keine technischen Lösungen für genuin gesellschaftliche Probleme.

Technikkritik mit großem »K«

Die konkreten Ansätze von Hoffmann und Benjamin sind bei weitem nicht die einzigen ihrer Art und stehen hier nur exemplarisch für eine andere Art der Technikethik und -kritik. Ihr Gegengewichtscharakter liegt in ihrer fundamentalen Einbeziehung sozialer Strukturen und in ihrer Ablehnung technokratischer Rationalisierungsversuche. Wie auch immer man zu der Methodenunterscheidung zwischen kritischer Theorie mit großem und kleinem »K« stehen mag; die Kritische Theorie in Frankfurter Tradition kann diesen Anspruch nur unterstützen, blickt sie doch selbst auf eine reiche Tradition der Kritik an rein instrumenteller Vernunft zurück. Marcuses eindimensionaler Mensch lässt grüßen, wenn diskrete Lösungen für diskrete Probleme gefordert werden. Noch immer haben wir es mit einer Symbiose von Rationalisierung und Kapitalinteressen zu tun, die große soziale Fragen operationalisierbar macht und damit in die Hände technischer Fachkräfte legt. Wieso also fühlt sich die Kritische Theorie mit großem »K« nicht zu der Thematik berufen?

Dass dem so ist, mag auch die Folge des traditionellen Technikverständnisses der Frankfurter Schule sein. So legen zumindest Gerard Delanty und Neal Harris9 nahe: Die Frage nach der Technik wäre von späteren Generationen der Frankfurter Schule vernachlässigt, von Habermas sogar explizit abgelehnt worden, als Konsequenz des grundlegenden Technikverständnisses der ersten Generation. So wäre Technik auch von der ersten Generation vor allem als die Sphäre der Zweckrationalität kritisiert und nicht etwa als ein sozio-kulturelles Phänomen konzeptualisiert worden, wie es noch im altgriechischen Begriff technē impliziert ist. Forderungen nach einer »Neuen Wissenschaft« und »Neuen Technik« wie sie zwar von Herbert Marcuse geäußert wurden, schienen im Nachgang aufgrund dieser eingeschränkten Technikkonzeption unglaubwürdig, fast realitätsfern. So versteht spätestens Habermas Technik als grundsätzlich neutral, als rein instrumentelle Vernunft und vor allem als außerhalb der sozialen Sphäre kommunikativer Vernunft. Die Frage nach der Technik wird zur Frage nach der hinreichenden Eingrenzung des technischen Einflussbereichs.

Natürlich kann und sollte man Technik dafür kritisieren, wenn sie ihren berechtigten Einflussbereich überschreitet und zu Ideologie wird. Es wäre begrüßenswert, wenn die Kritische Theorie ihre klassische Kritik an zweckrationaler Effizienzorientierung auf aktuelle KI-Debatten anwenden würde. Die Idee etwa, dass ethische Praxis in die KI-Algorithmen selbst zu verlegen ist, verdient eine kritische, oder eher Kritische, Analyse. Auch die fortschreitende technische Nutzung und Nutzbarmachung der sozialen Sphäre (»datafication«) sowie die technische Einflussnahme hierauf (ChatGPT, »Deepfakes«, Cambridge Analytica, u.v.m.) sollte die Kritische Theorie interessieren.10

Jedoch können Kritische Theoretiker*innen in diesen Fällen berechtigterweise einwenden, dass dies streng genommen keine Kritik an der Technik selbst, sondern viel mehr an den gegebenen gesellschaftlichen Herrschaftsverhältnissen und Ideologien darstellt, die, so viel ist sicher, in der Kritischen Theorie sehr wohl stattfindet. Eine solche Einstellung findet sich instanziiert im IfS Working Paper Nr. 20, welches zukünftige Forschungsperspektiven des Instituts zur Debatte stellt und dabei Technik ausschließlich im Zusammenhang von Technosolutionismus und Technokratie erwähnt, jedoch nicht ausdrücklich behandelt.11

Davon abgesehen liegt in diesen Analysen außerdem nicht die eigentliche Stärke der Kritischen Theorie. Diese liegt vielmehr in der robusten Ausarbeitung methodischer Grundlagen, die zum Teil auch kritische Ansätze mit kleinem »K« inspirieren. Zentral herausgestellt werden muss vor allem die Methode der immanenten Kritik, die, sehr verkürzt wiedergegeben, die Normativität sozialer Praktiken mit sozialen Realitäten und deren historischer Entwicklung konfrontiert. Eine immanente Kritik der Technik fordert somit mehr als nur die Einschränkung der Zweckrationalität in die ihr zugeteilte Sphäre.

Von Technik zu Technologie

Hierin kann der spezifische Beitrag der Kritischen Theorie liegen, der noch viel zu selten eingelöst wird. Denn mit dem Anspruch, Technik immanent zu kritisieren, muss zwingend ein anderes Technikverständnis einhergehen. Immanente Kritik zielt immer auf in sich normative soziale Praktiken als ihr Objekt. Technik als reine Zweckrationalität kann hierzu nicht dienen. Damit Technik also zum Objekt Kritischer Analysen werden kann, muss sie als normative soziale Praktik aufgefasst und zu Technologie werden. Nur dann kann die Theorie sich im Sinne einer immanenten Kritik mit sozio-technologischen Krisen auseinandersetzen und transformative Potentiale identifizieren. Dies erfordert jedoch eine Konzeption, die versteht, dass Technologie sich nicht nur in eine Richtung entwickeln kann – Zweckrationalität determiniert technologischen Fortschritt nicht vollständig.12

An dieser Stelle sei auf die Werke Andrew Feenbergs verwiesen, welcher sich genau diese Argumentationslinie zu eigen macht und damit den Grundstein für eine Technikdebatte in Frankfurter Tradition legt. Feenberg versteht das vorherrschende Techniksystem, d.h. die Gesamtheit der technischen Sphäre, als nicht weniger sozial konstituiert als andere institutionalisierte soziale Praktiken. Funktion und Effizienz sind keine neutralen Attribute, sondern kulturell-politisch aufgeladene Kategorien. Ob etwa eine Spinnmaschine »effizient funktioniert« wird vor allem dadurch bestimmt, für welche Art der Produktion sie gedacht ist, ob für den Eigenbedarf im familiären Kontext oder für die Fabrikproduktion unter Kinderarbeit. Entsprechend sozialer Erwartungen und Kontexte wird Technologie designt, modifiziert und weiterentwickelt. So spiegelt die Ausgestaltung von Technologie immer auch die vorherrschende soziale Ordnung wieder und reifiziert im Gegenzug deren Strukturen.

Letzteres hatten wir bereits im Kontext von KI Bias und Fairness verstanden. Doch eine Konsequenz dieses Verständnisses muss deutlicher herausgestellt werden: Erschöpft sich Technologie nicht in Zweckrationalität, wird andere Technologie vorstellbar; immanente Kritik hat immer ein transzendierendes Moment. Diesem Geiste entspringt Feenbergs Fazit, das sich fast wie ein Appell liest: »In a society where determinism stands guard on the frontiers of democracy, indeterminism is political. If technology has many unexplored potentialities, no technological imperatives dictate the current social hierarchy. Rather, technology is a site of social struggle […] on which political alternatives contend.”13 So lassen sich Technologien schon heute aktiv verändern, und nicht erst als Ergebnis einer vorangehenden gesellschaftlichen Veränderung. Denn es gibt keine technischen Lösungen für genuin gesellschaftliche Probleme – allerdings ist Technologie ein genuin gesellschaftliches Problem.

Nur mit einem solchen Verständnis kann die kritische Theorie, die Größe des »K« einmal beiseitegestellt, Aussagen wie der, dass die Weiterentwicklung von KI-Technologien in jetziger Form unvermeidbar ist14, etwas entgegenhalten. Denn in diesem Punkt hat OpenAI recht – es macht einen Unterschied von wem, durch wen und für wen KI entwickelt wird. Die Interessen der undifferenzierten »Menschheit«, definiert durch eins der wertvollsten Start-Ups der Welt, sind in diesem Zusammenhang jedoch wohl kaum die beste Richtschnur.

Mit Blick auf die Zukunft

OpenAI’s »Sora«-Modell befindet sich indes in der sogenannten »red teaming«-Phase. Ein ausgesuchtes Team an Expert*innen bekommt die Gelegenheit, Sora auf Risiken und Schadpotential zu prüfen. In einem Interview mit dem Wall Street Journal vom 13. März 2024 kündigt Mira Murati, CTO von OpenAI, an, Sora würde noch in diesem Jahr vorgestellt werden. Dennoch ginge es nicht um schnellen Profit – ernstzunehmende ethische und soziale Bedenken würden auch die CTO nachts wachhalten. Doch Sora sei es allemal wert. Für die Menschheit, versteht sich. KI-Anwendungen würden unsere Kreativität und unser Wissen, unsere kollektive Vorstellungskraft, ja, unsere Fähigkeiten insgesamt erweitern, so Murati.15 Hinter Sora gibt es also kein Zurück mehr. OpenAI hat unsere Zukunft schon für uns in Planung. Bevor es soweit kommt, sollten wir versuchen, endlich ethische Antworten auf die Frage der Technik anstatt bloß technische Antworten auf die Frage der Ethik zu finden.